QEUR23_LLMDSS6: (オリエンテーション)ユーザーがfinetuneしたモデルを使用することの重要性

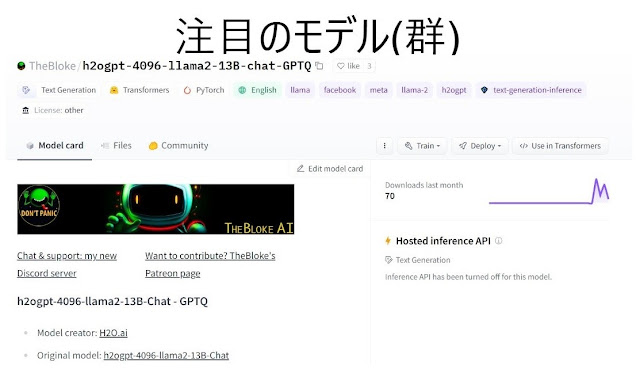

~ これは、とても重要なオリエンテーションです ~ D先生 : “別のブログでLangChain(Vector Store)の応用のプロジェクトが終わり、やっと、この「fine tuning」のブログに戻ってきました。・・・、いや、いままで長かった・・・(笑)。” QEU:FOUNDER : “それにしても、LangChainを使うことによって、LLMの応用の広さと深さをより理解できましたね。今回は、ちょっと「深い」オリエンテーションです。。” C部長 : “これ(↑)って、大きな問題になっていますが、偉い人によると問題ないんでしょ? 「meti」とかいう、「健康に責任を持つ省」が安全といっている んだし・・・。” C部長 : “処理した後の水には 「トリチウム」しかない んでしょ?” D先生 : “どうなんでしょうね。とある、 有名なジャーナリスト のツイッターを参考にしましょう。” QEU:FOUNDER : “とても残念ながら、あの水にはストロンチウムとセシウムが少量ながら残留しているようです。” (ストロンチウム) (セシウム) C部長 : “でも少量なんでしょ?健康に影響はないんでしょ?” QEU:FOUNDER : “それでは、この2つの物質について調べてみましょう。まずは、我々が今まで使ってきたLlama2からしらべましょう。” # llama2-13B-chat-GPTQによる単発LLM回答プログラム import pandas as pd import numpy as np from langchain import HuggingFacePipeline from langchain import PromptTemplate , LLMChain from transformers import AutoTokenizer , pipeline , logging from auto_gptq import AutoGPTQForCausalLM , BaseQuantizeConfig # モデル名 model_name_or_path = "TheBloke/Llama-2-13B-chat-GPTQ...